最新脑筋急转弯大全 【NLP】让GPT-3、ChatGPT、GPT-4一起做脑筋急转弯,GPT

夕小瑶科技说 原创

作者 |

一个烙饼煎一面一分钟,两个烙饼煎两面几分钟?

让你来回答,是不是一不小心就掉到沟里了?如果让大语言模型来做这种脑筋急转弯会怎样呢?研究发现,模型越大,回答就越可能掉到沟里,即使是拥有千亿参数的大模型也不能幸免。但是却能很好回答这些问题。让我们一起来看看吧。

论文题目:

-Like and in —and in GPT-4

论文链接:

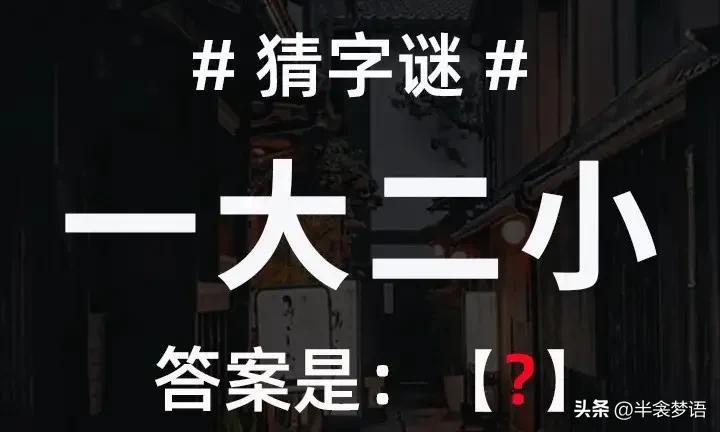

脑筋急转弯

作者采用了CRT( Test)数据作为脑筋急转弯的测试数据。该数据在心理学领域,广泛地被用于衡量人类的思维习惯,判断是否习惯于直觉思维。

▲脑筋急转弯数据示例

如上图所示,作者探索了3种CRT数据最新脑筋急转弯大全,和1种语言逻辑陷阱。例如:

模型表现

模型表现如下图所示,可以看到模型较小时(从117M GPT-1 到2.7B GPT-Neo),随着模型增大,模型回答正确答案(绿色)和直觉答案(红色)的比例在提高,回答无关答案(黄色)的比例在下降。但随着模型进一步增大(从2.7B GPT-Neo 到 175B GPT-3),无关答案比例进一步下降,直觉答案比例进一步上升,正确答案比例却不升反降。包括、、GPT-3在内的大语言模型明显掉入脑筋急转弯的陷阱。即使是经过指令调整与RLHF的text -002/003也未能幸免。

▲不同模型表现对比

而在上图中,经过指令调整的与GPT-4,一下子正确答案的比例就高了许多。究竟是什么魔法使得的脑筋会转弯呢?我们不得而知。

下图具体对比了GPT-3(text -003,左)、(中),GPT-4(右)在几类不同的脑筋急转弯的表现,可以更加凸显上述现象。

▲不同脑筋急转弯类型上的模型表现对比

如果改换输入形式会怎样?下图上为问答的形式,和上面的实验相同。下图中、下分别为多选、续写的形式。可以看到,修改提问形式之后,正确率略有上升,但整体差别不大。

下图显示,通过少监督展示学习,GPT-3的正确率会有所上升。但即使展示到40个左右的样本,准确率和无监督的比仍有差距,更不用说GPT-4了。

结论

这篇论文针对很有意思的一类问题(脑筋急转弯)最新脑筋急转弯大全,发现了大语言模型的一个很有意思的现象。作者也尝试了多种方法,但无论是改变提问形式还是增加监督数据最新脑筋急转弯大全,GPT-3(text -003)在脑筋急转弯上的表现仍然难以达到的水平。究竟使用了怎样的魔法让模型的脑筋会转弯呢?

往期精彩回顾适合初学者入门人工智能的路线及资料下载(图文+视频)机器学习入门系列下载机器学习及深度学习笔记等资料打印《统计学习方法》的代码复现专辑机器学习交流qq群955171419,加入微信群请扫码

免责声明:本文系转载,版权归原作者所有;旨在传递信息,不代表本站的观点和立场和对其真实性负责。如需转载,请联系原作者。如果来源标注有误或侵犯了您的合法权益或者其他问题不想在本站发布,来信即删。